In einem Weihnachtsfilm habe ich einmal folgenden Text gehört: „Suche nie medizinischen Rat im Internet. Ich komme von Kopfschmerz bis klinisch tot mit drei Mausklicks.“ 😁

Heutzutage greifen immer wieder Menschen auf künstliche Intelligenz zurück, um medizinische Ratschläge zu erhalten. Besonders beliebt sind dabei Chatbots wie ChatGPT. Solche Chatbots schnattern allzu redselig darauf los, wenn es um Anfragen zu Symptomen und mögliche Diagnosen geht. Aber ein Chatbot kann den Kontext nicht komplett einschätzen, bekommt vermutlich keine komplette medizinische Akte vom Anwender und kann den Patienten weder sehen noch hören. Eine Maschine ist eben kein Arzt. Dementsprechend können die statistischen Voraussagen für den Antworttext sich auch nur auf die Eingabe eines medizinischen Laien beziehen.

Menschen sind auch skeptisch

Ebenso gibt es Menschen, die genau das nicht tun, denn sie vertrauen der KI nicht. Nicht unbedingt, weil sie wissen, dass die Abfrage eines Chatbots durch einen Laien mit einem Arzt nicht mithalten kann, sondern weil sie einer KI misstrauen. Ein Computer kann eben nicht empathisch sein wie ein Mensch. Das könnte allerdings zu einem Vertrauensproblem bei Patienten führen, wenn Sie sehen, dass Ärzte selbst KI-Assistenzen zur Diagnosestellung einsetzen.

Letztlich bedeutet das, dass ein gewisser Teil der Menschen die medizinische Kompetenz einer KI anzweifelt. In der Konsequenz würden Patienten einer KI-gestützten ärztlichen Anweisung vielleicht nicht folgen – wenn sie es wissen. Eine aktuelle Studie im Fachmagazin „Nature Medicine“ belegt das durch einen Versuch mit 2.280 Patienten.

Studien-Setting und Ergebnis

Die Studie untersucht die öffentliche Wahrnehmung von medizinischen Ratschlägen, die von großen Sprachmodellen (LLMs) generiert werden, insbesondere im Vergleich zu Ratschlägen von menschlichen Ärzten. Den Teilnehmern wurden identische medizinische Ratschläge präsentiert, doch man gab unterschiedliche Quellen an. Einem Teil der Personen wurde gesagt, die Ratschläge stammen von einer KI. Einer anderen Gruppe sagte man, die Ratschläge stammen von einem Arzt. Und schließlich sagte man einer dritten Gruppe, die Ratschläge stammen von einer KI und seien von einem Arzt geprüft. Es ging also darum, gezielt die Vorurteile abzuklopfen.

Und tatsächlich wurden alle Ratschläge, die angeblich von einer KI oder einer KI und Arzt stammten, als weniger zuverlässig und weniger empathisch wahrgenommen. In Wirklichkeit waren sie aber alle identisch und gleich verständlich. Die Teilnehmer äußerten auch, dass sie weniger geneigt waren, den KI-Ratschlägen Folge zu leisten.

KI in der Medizin bedarf Transparenz

Für einen erfolgreichen Einsatz von KI ist offenbar die Akzeptanz der Patienten entscheidend. Eine transparente Kommunikation darüber, wie ein KI-Assistenzsystem zu seiner Diagnose kommt, könnte das Vertrauen der Patienten stärken. Damit ist das Gebiet der sogenannten erklärenden KI betroffen. Ebenso sollte klar geregelt sein, dass die endgültige Entscheidungsgewalt immer bei einem menschlichen Arzt liegt. Anderenfalls könnte das Vertrauensverhältnis zwischen Patient und Arzt gefährdet werden.

Selbsteinschätzung von ChatGPT

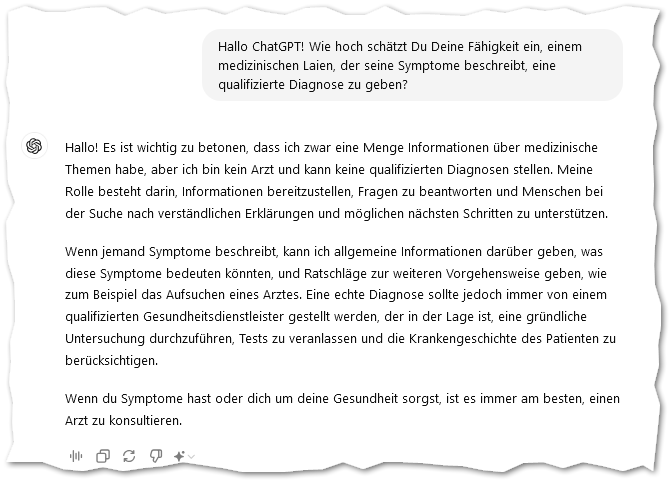

Fragt man ChatGPT nach seinen diagnostischen Fähigkeiten, so ist gut zu erkennen, dass die KI darauf trainiert wurde, ihre Grenzen zu kennen.

Hallo ChatGPT! Wie hoch schätzt Du Deine Fähigkeit ein, einem medizinischen Laien, der seine Symptome beschreibt, eine qualifizierte Diagnose zu geben?

ChatGPT: Hallo! Es ist wichtig zu betonen, dass ich zwar eine Menge Informationen über medizinische Themen habe, aber ich bin kein Arzt und kann keine qualifizierten Diagnosen stellen. Meine Rolle besteht darin, Informationen bereitzustellen, Fragen zu beantworten und Menschen bei der Suche nach verständlichen Erklärungen und möglichen nächsten Schritten zu unterstützen.

Wenn jemand Symptome beschreibt, kann ich allgemeine Informationen darüber geben, was diese Symptome bedeuten könnten, und Ratschläge zur weiteren Vorgehensweise geben, wie zum Beispiel das Aufsuchen eines Arztes. Eine echte Diagnose sollte jedoch immer von einem qualifizierten Gesundheitsdienstleister gestellt werden, der in der Lage ist, eine gründliche Untersuchung durchzuführen, Tests zu veranlassen und die Krankengeschichte des Patienten zu berücksichtigen.

Wenn du Symptome hast oder dich um deine Gesundheit sorgst, ist es immer am besten, einen Arzt zu konsultieren.

Mehr lesen:

- Reis, M., Reis, F. & Kunde, W. Influence of believed AI involvement on the perception of digital medical advice. Nat Med (2024). https://doi.org/10.1038/s41591-024-03180-7