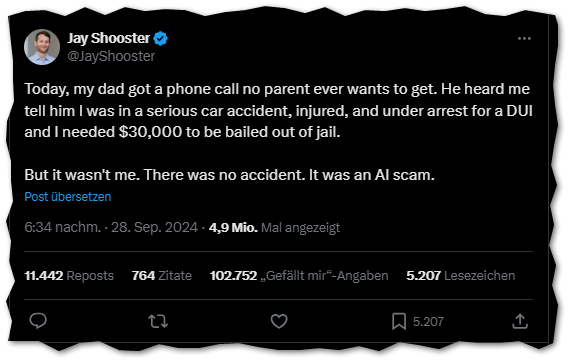

Es gibt einen weiteren öffentlich gewordenen Fall Betrugsversuch mit einem KI-Doppelgänger. Der Anwalt und Politiker Jay Shooster tweetete auf X, dass sein Vater einen betrügerischen Anruf erhalten habe. Dieser erhielt einen Anrufer mit der Stimme von Jay Shooster. Der Anrufer behauptete, er hätte einen schweren Unfall gehabt und sei wegen Fahrens unter Alkoholeinfluss verhaftet worden.

Der Angriff verlief ins zwei Stufen. Zunächst kam ein Anruf, in dem der KI-Clone nur mitteilte, dass er einen Unfall gehabt habe und nach der Behandlung im Krankenhaus verhaftet wurde. Anschließend rief ein „Anwalt“ an und teilte mit, Jay bräuchte 35.000 US-Dollar für die Kaution. Der Betrug flog auf, weil der Anrufer wollte, dass sein Vater das Geld per Kryptowährung überweisen solle. Daraufhin wurde dieser misstrauisch und beendete den Anruf.

Jay Shooster vermutet, dass die Betrüger seine Stimmaufnahme aus einem Fernsehbeitrag verwendet haben. Jay kandidiert für den 91. Bezirk von Florida im Repräsentantenhaus. Wenige Tage vor dem Vorfall lief im Fernsehen ein 15-sekündigen TV-Wahlkampfspot mit seiner Stimme. Wie bereits aus anderen Doppelgängerkampagnen und Ähnlichem bekannt ist, benötigen KI-Systeme inzwischen nur noch wenige Sekunden Ton- oder Bildmaterial, um einen kompletten erschreckend echten KI-Avatar zu generieren.

Der Betrugsversuch hat meines Erachtens eine pikante Note. Jay hat als Verbraucherschutzanwalt in Umwelt-, Tierschutz- und Arbeitsrechtsorganisationen gearbeitet und hat erreicht, dass viele irreführende Marketingaussagen unterlassen werden mussten. Er setzt sich darüber hinaus als AI Policy Fellow am Center for the Future Mind der Florida Atlantic University für eine verantwortungsvolle KI-Regulierung ein. Er steht also auf der Seite, die von Unternehmen Verantwortung dafür einfordert, was ihre Produkte beim Verbraucher bewirken.

Mehr dazu:

- Fla. pol targeted in elaborate AI ‘car crash’ scam — which almost fooled his dad into forking over $35K, New York Post, 08.10.2024

- Homepage von Joy Shooster